在现代科技飞速发展的时代,激光测距传感器作为精确测量领域的关键设备,其应用广泛涉及到工程测量、机器人导航、无人驾驶等多个领域。激光测距传感器的核心在于其能够提供快速、精确的距离信息,而这些信息的准确性很大程度上取决于背后支撑的数学模型。本文旨在深入探讨激光测距传感器背后的数学原理,揭示这一高精度设备的工作机制。

第一段:激光测距传感器基础

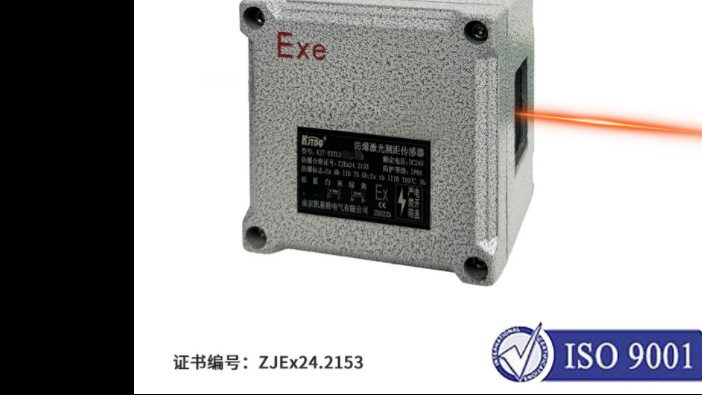

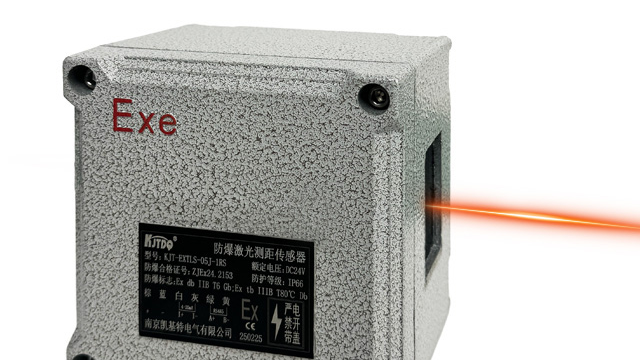

激光测距传感器通过发射激光束到目标物体上,并接收反射回来的光束来测量距离。这种技术通常被称为时间飞行(Time of Flight, ToF)测距法。在这一过程中,激光的发射与接收之间的时间差被用来计算传感器与目标物体之间的距离。这一过程看似简单,但实则包含了复杂的物理和数学运算。

第二段:数学模型的核心

在激光测距传感器的数学模型中,光速是一个关键常量。由于光速是已知且恒定的(大约为每秒299,792公里),通过测量激光往返的时间,可以计算出激光行进的总距离,进而得出与目标物体之间的半距离。然而,要实现高精度的测量,就必须考虑到多种误差来源,如大气折射率的变化、温度的影响等,这就引入了更加复杂的数学校正模型。

第三段:误差校正与优化

为了提升激光测距传感器的测量精度,研究者开发了一系列误差校正算法。这些算法利用高级数学模型对原始数据进行处理,修正由环境因素引起的误差。例如,温度变化会影响激光的传播速度,因此传感器内部通常会配备温度补偿算法。此外,对于非理想表面的反射特性也需建模分析,以减少由此产生的误差。

第四段:数学模型在实际中的应用

将数学模型应用于激光测距传感器的设计和数据分析中,不仅提高了测量精度,还扩展了其在各行各业中的应用范围。在自动驾驶汽车中,精确的距离测量能够确保车辆安全行驶;在建筑工程中,激光测距传感器帮助工程师进行精密测量和施工指导;在机器人技术中,传感器的数据支持机器人进行空间定位和避障。

随着技术的不断进步,激光测距传感器的数学模型也在不断地优化与更新,以适应更加复杂与多变的应用需求。通过对数学模型的深入研究和应用,我们能够解锁激光测距传感器更多的潜力,推动相关领域的技术革新,从而步入一个更加精准和智能的未来。